[Här nedan publiceras i tämligen oredigerat skick den professorsföreläsning som jag höll den 8 maj 2025.]

I Alf Prøjsens klassiska barnbok Killing som kunde räkna till tio så skildras hur olika djur tvekar inför att låta sig räknas. Både hästen och suggan undrar hur killing bär sig åt, och kalven är rädd för att det ska göra ont. Kalven råmar bestört ”Hjälp, nu räknar han dej också.”

Missnöjda jagar de den lilla kalven ombord på en liten båt, men väl där blir räkningen helt avgörande för att farkosten inte ska sjunka. Slutsatsen är tydlig; vi skall låta oss räknas, eller för den delen mätas, då att reduceras till ett nummer kan vara högst effektivt i en situation där ett beslut måste fattas. Samtidigt vittnar djurens inledande tveksamhet till killingens räknande på en insikt om mätandet och räknandet så kallade performativa natur; när något mäts förändras det.

Denna föreläsning behandlar hur vetenskaplig produktion mäts, och hur system för utvärdering har kommit att påverka hur forskning bedrivs och kommuniceras. Fokus ligger på den specifika form för att utvärdera vetenskaplig produktion som går under namnet bibliometri. Bibliometri kan definieras som kvantitativa studier av publikationer och deras egenskaper, eller utan krusiduller räknandet av artiklar, böcker och allt annat som forskare producerar. Ett särskilt fokus riktas mot de konsekvenser – i form av exempelvis förändrade publikationsmönster – som ett alltför stort fokus på indikatorer och utvärderingssystem kan få. Syftet är att ge en koncis och nyanserad bild av hur ett ökat fokus på mätning kommit att påverka forskningen. Men räknandet och mätandet är på intet sätt unikt för akademin, utan kan sägas prägla det senmoderna samhället i stort. Räknandet betydelse – inom vetenskapen idag, och i stort – är menar jag kopplat till övergripande förändringar i hur verksamheter styrs, hur vi som individer ser på oss själva, och i hur vi ser på tid och tempo. Jag kommer inom kort återkomma till samtiden, men låt oss först unna oss en kortare historisk återblick.

Enligt en judisk-kristen tradition så var Kain den som uppfann mätandet och vägandet, uppfinningar som fyllde en dittintills oskyldig och enkel värld med oärlighet. Mätandet är alltså redan från start associerat med fusk, och i den bibliska traditionen med synd. I det följande kommer vi se hur tanken att mätandet också innebär att något går förlorat återkommer. Det kan handla om en mer abstrakt förlust av förtroende, eller av mer konkreta inskränkningar i den vetenskapliga professionens möjligheter till självstyre. Ett återkommande tema är den ambivalens som omgärdar mätandet. Ibland kunde mätning ses som direkt farlig, exempelvis så sades det i 1800-talets Tjeckien att barn under sex år fastande i växten ifall deras längd registrerades. Mätandet var dock inte bara av ondo. I medeltidens Polen fanns en åkomma, kallad ‘miara’ (polska för mått), som bara kunde botas genom att sjuklingen mättes. Tidigt fanns det alltså insikter om att mätandet påverkade det som mättes, om dessa effekter var positiva eller negativa rådde det större oenighet om. Denna ambivalens är också uppenbar när vi förflyttar oss till samtiden och till utvärderandet av vetenskapliga alster. Vi lever i ett granskningssamhälle där allt skall genomlysas, bedömas och utvärderas. Peter Dahler-Larsen, en dansk professor som författat en bok om utvärderingsssamhället, uttrycker det som att vi har svårare att föreställa oss ett samhället utan utvärdering, än att tänka oss att ett gäng utomjordingar landade på jorden. Och räknar vi de dagliga utvärderingssituationerna så är de många: varje inköp följs av en enkät som vill veta vad vi tycker, filmen som vi just såg på Netflix vill bli bedömd (var det en 1:a elle en 5:a), För några veckor sen så var jag med en granne och hjälpte honom att tömma sitt hyrda förråd inför flytt, och till och med då kommer frågan: ”Hur var din magasineringsupplevelse idag”? Just i dagarna presenterade en av döttrarna en hylla som hon gjort i slöjden: men hem till föräldarna kom också en detaljerad ifylld blankett med rubriken: ”Utvärdering: hylla” där reflektioner kring material (spik, skruv, trä, färg ) och metod redogjorde för i detalj. Kort sagt: Det är som hela samhället skriker: bedöm mig! Snälla!

Det framstår som mer oklart när och hur utvärdering blev en sådan central aktivitet. De grundläggande idéerna kring rationalitet, och kontinuerlig förbättring, av verksamheter genom någon form av utvärdering kan spåras långt tillbaka i tiden. Det utvärderingssamhälle som exempelvis Marilyn Strathern beskriver kan kopplas samman med den framväxande moderniteten, och den rationalitetssträvan som sammankopplas med denna idétradition. Här spelar samtidens besatthet av att minimera risker, utförligt beskrivet av som den tyske sociologen Ulrich Beck – en central roll. För räknandet är den primära metod på vilket vi kan omvandla oberäkneliga faror till kalkylerbara risker. Exempelvis: en fara med att helt simpelt ge forskare resurser att bara utforska det de finner viktigt är ett vågsspel (kanske lägger de sin tid på fel saker, kanske bara latar de sig) men genom att räkna – t.ex. antal publikationer, eller citeringar, – så hoppas vi kunna minimera (och kontrollera) denna risk.

Även gällande bibliometrin går det att hitta flera ursprungshistorier. Försök att under det sena 1800-talet fastställa hur vetenskaplig excellens bäst främjades kan sägas vara starten för ett mer kvalificerat mätande. Psykologen, och rasbiologen, Francis Galton hävdade bestämt att arvet var av avgörande betydelse för vetenskaplig excellens. Konstruktören av den första universitetsrankingen – James Mckeen Cattell – följde Galtons logik, och hans slutsats var enkel: eftersom söner till professorer var klart mer benägna att bli vetenskapsmän så var det främsta sättet att främja vetenskap helt enkelt att se till att professorer fick många barn (kvinnornas roll nämndes knappat alls).Till skillnad från sina anglosaxiska kollegor så framhöll den franske botanikern Alphonse de Candolle miljön. Idag kan vi nog med bestämt hävda att Candolles linje är den helt dominerande – och bibliometriska undersökningar syftar inte sällan till att studera vilka miljöer som främst gynnar god vetenskap, med en tanke att lära från dessa. Exempelvis kan det rör frågan kring hur pass mycket frihet forskarna bör ha, hur forskning ska finansieras, och hur akademiska organsationer ska styras, vilka samarbeten som är mest gynnsamma etc.?

Under 1900-talet växte sedan bibliometrin gradvis fram som ett forskningsfält och redan 1934 använde biblioteksutopisten Paul Otlet just termen ‘bibliometri’ för första gången. Dess betydelse, både som vetenskaplig specialitet och som utvärderingsinstrument, kom att öka allteftersom större datamängder blev tillgängliga för analys.

Utanför fältet ses dock ofta bibliometrin som ett relativt nytt påfund, som del av en större trend av nyliberalt tänkande och akademisk kapitalism. Föreställningen om liberala marknadsidéer som drivande för bibliometrins etablering ackompanjeras inte sällan av föreställningen att alla dessa mätsystem kommer utifrån, och att de är ett sätt för klåfingriga politiker, tjänstemän och chefer att kontrollera forskarna på.

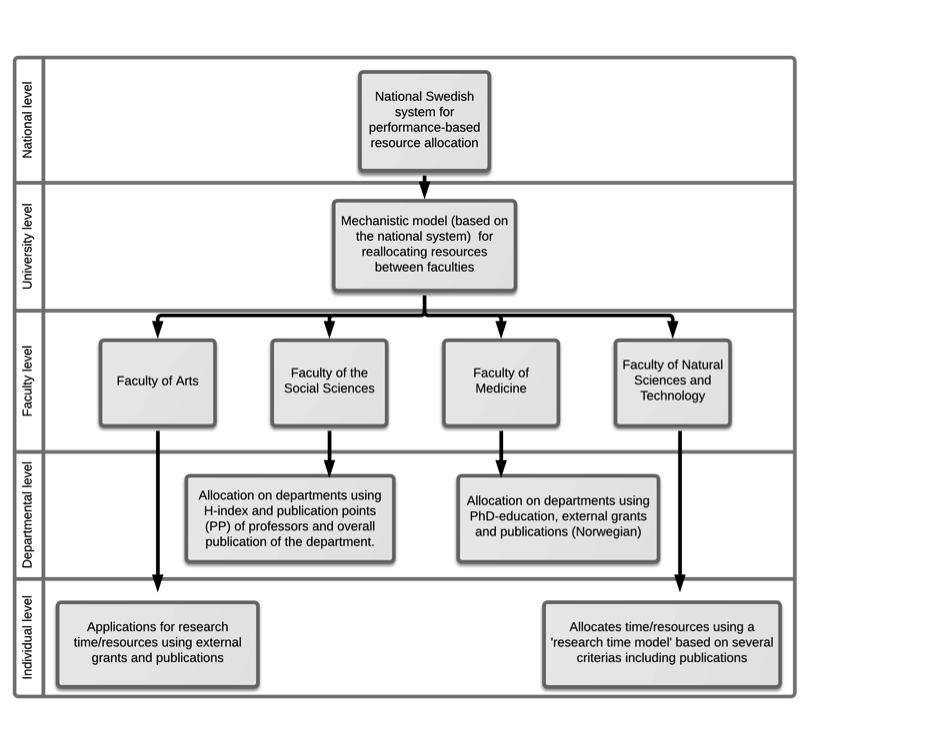

En populär förklaring till mätandets intåg stavas NPM (New public management). Vanligen betraktas NPM som ett resultat av högerliberala idéer om marknadens överlägesenhet i ett fördela resurser, men styrformen kan också relateras till en mer allmän tendens där offentlig verksamhet ska hållas ansvarig inför medborgare och skattebetalare. NPM har inneburit att offentliga verksamheter allt mer har kommit att präglas av tre M: managers, mätning och marknad. Dessa tre M påverkar akademin i olika grad. Det kan konstateras att de tre M:en är kopplade: ökad mätning möjliggör administrativ styrning (managers) vilket i sin tur medför att den professionella (eller kollegiala) styrningen ifrågasätts. Den bibliometriska mätningen s bidrar också, genom mått på individuella prestationer och genom universitetsrankningar av olika slag, till etablerandet av en akademisk marknad av publikationer, citeringar och forskare.

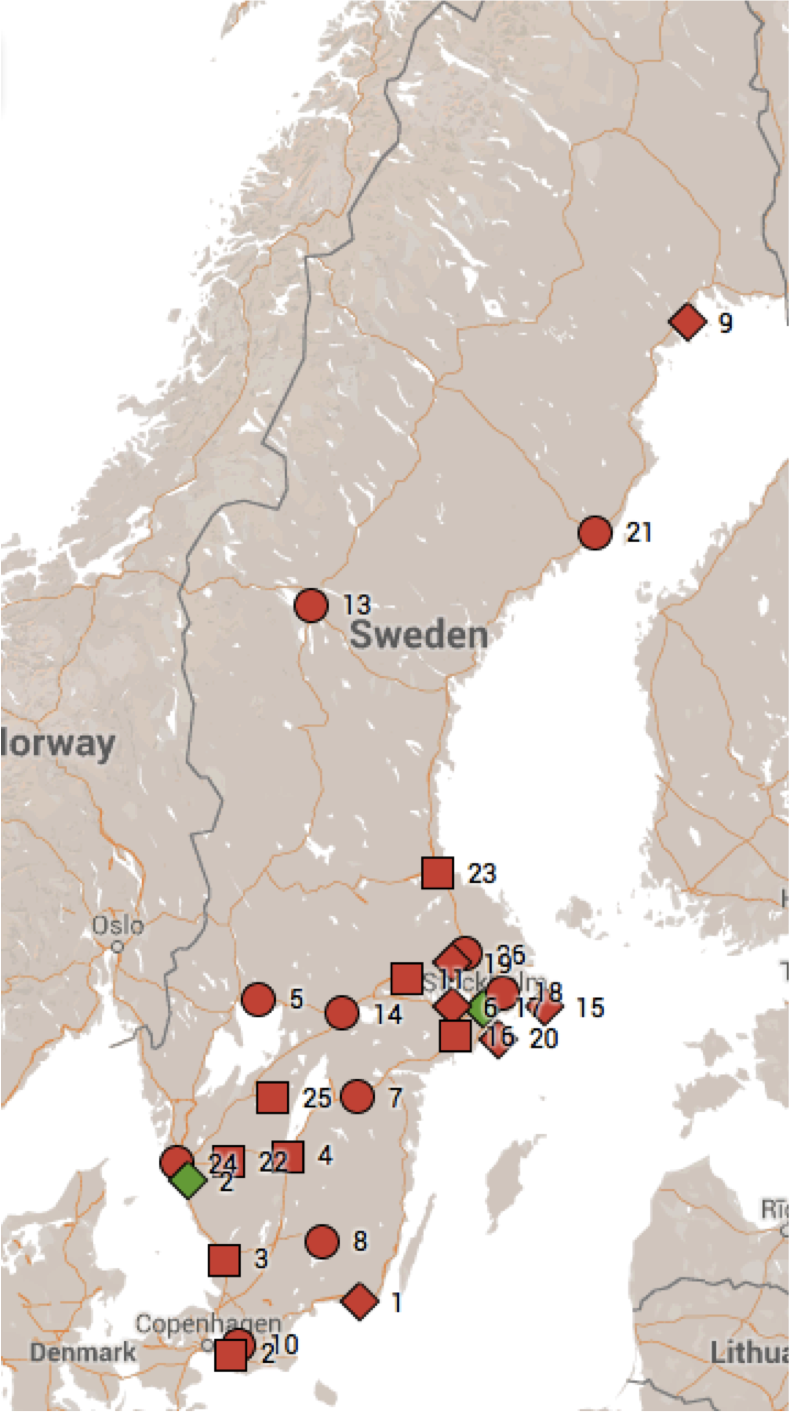

Nyliberalism är, som Olof Hallonsten och jag nyligen diskuterat, dock inget entydigt begrepp utan snarare en svepande benämning på en samling föreställningar om hur samhället, och akademin, bäst ska organiseras. Storbritannien under Thatcher var ledande i utvecklingen där länder som Australien, Danmark, Nederländerna och Sverige har följt efter. För vetenskapens del så bör det här beaktas att mätandet nog snarare ska kopplas till en ökad ekonomisering i offentlig sektor (som bland annat Elisabeth Pobb-Berman föreslagit) snarare än en renodlad rörelse mot nyliberalism inom akademin. Exempelvis är det tydligt att stater med stark statlig styrning är mer benägna att införa bibliometriska modeller en de med ett mer heterogent akademiskt landskap. (Vi kan exempelvis jämföra USA, eller Tyskland med de skandinaviska länderna).

Idén om vetenskapen som en marknad uttrycks kanske allra tydligast i de globala rankningar av universitet, och forskare, som årligen publiceras. Universitetsrankingarnas betydelse för universitetens självbild är uppenbar, och att rankas högt i dessa blir allt viktigare, inte minst ur marknadsföringssyfte. En återkommande nyhet är hur många svenska universitet som lyckats ta sig in bland de hundra bästa på någon av de mest prestigefyllda listorna. Oroväckande många ser rankningarna– vars metodologi starkt kan ifrågasättas– som en faktisk illustration av hur Sverige står sig om kunskapsnation. Vad man lätt glömmer bort är att rankningar säger mycket lite om absolut kvalité: Att Sverige hitintills lyckats behålla 4-5 universitet bland de 100 ”bästa” i flertal rankingar är imponerande, men knappast realistiskt i framtiden där alltfler länder satsar alltmer på forskning. Trots detta används dessa rankningar inte sällan som slagträ i den forskningspolitiska debatten, och inte sällan misstänker jag att de används mot bättre vetande. Och det är genomgående för bibliometriska mått: de flesta vet att de är problematiska, men vi använder dem ändå – i brist på annat.

Hur bibliometriska mått påverkar kunskapsproduktionen mer generellt är annars svårt att överblicka, och kanske är det ännu för tidigt att identifiera djupgående förändringar. Det vi vet tyder ändå på att användning av bibliometriska mått kan få konsekvenser i form av en ökat fokus på de kriterier som ställs upp av en disciplinär elit. Detta kan resultera i en likriktning av vetenskapliga fält och en reduktion av forskarrollen. Sådana förändringar står i direkt opposition till forskning som går dialog med omgivande samhälle och söker svara på samtidens stora utmaningar.

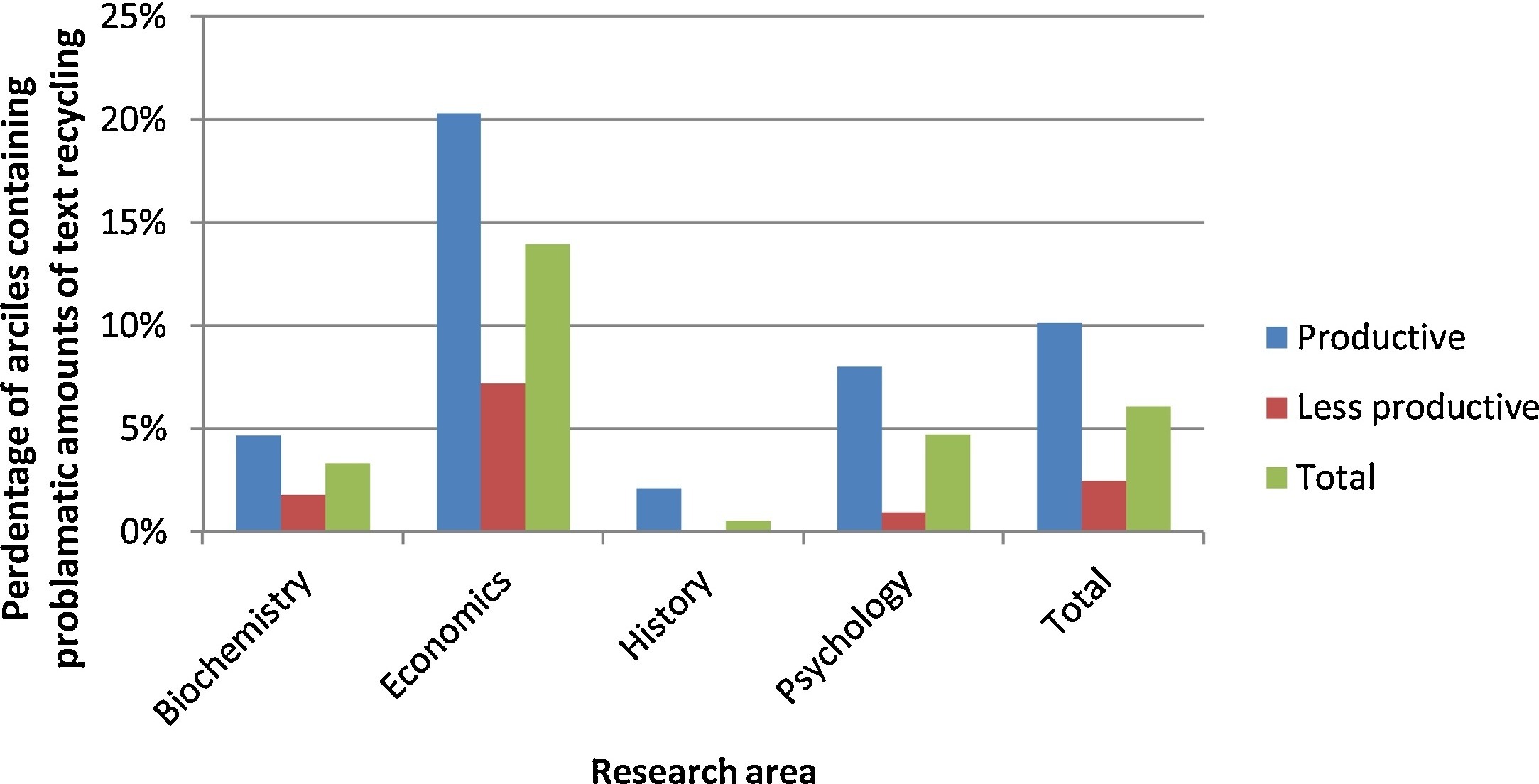

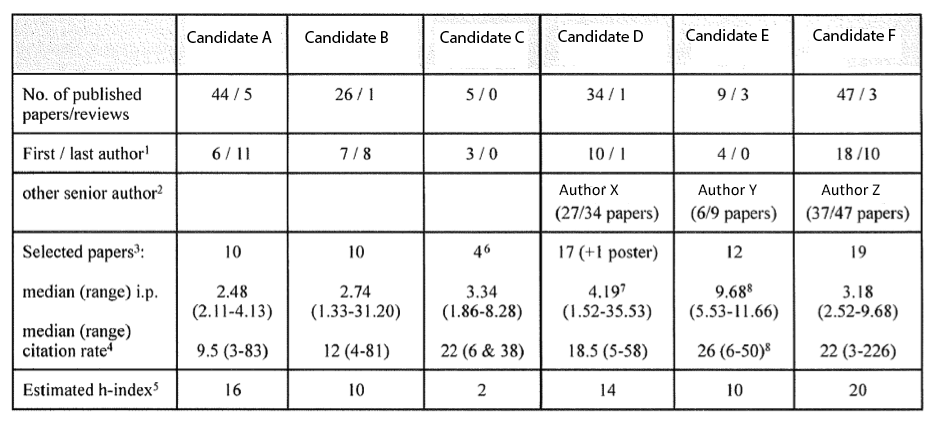

Sammantaget är det just möjligheten till att reglera och överblicka den svårstyrda fria forskningen som gör bibliometrin så attraktiv som mätmetod både bland forskarna själva, och bland beslutsfattare. Ett problem med denna typ av styrning är dock att det lätt uppstår konflikter mellan vad professionen anser som viktigast och det som systemen anbefaller. Exempelvis har det observerats hur forskare kramar ut så många publikationer ur ett projekt som bara möjligt; så kallad ‘salamipublicering’ (företeelsen går också under benämningen ‘minsta-publicerbara-enhet’). Vidare kan mer strategiska överväganden ske då forskare kan tänkas satsa på relativt ‘säkra’ eller kortsiktiga projekt som med stor sannolikhet kan utmynna i publicerbara resultat snarare än att investera i mer riskabel och utdragen, men potentiellt mer nydanande, forskning. Försöken att konstruera indikatorer som på basis av publikationer och citeringar skall mäta forskningens kvalité är ett annat exempel på denna diskrepans. Även om det idag råder konsensus om att citeringar i bästa fall kan betraktas som en indikation på synlighet och genomslag – snarare än som direkta kvalitetsmått – så spelar fortfarande bibliometriska mått en betydelelsefull roll i fördelningen av resurser och vid tillsättningar av akademiska tjänster. Istället för att bedöma utifrån de kriterier som vi anser bäst reflektera kvalité och relevans får tillgängliga data samt enkelheten i genomförande i hög grad styra utvärderingen.

Kritiken mot bibliometrisk utvärdering har, med rätta, varit särskilt hård från ett samhällsvetenskapligt och humanistiskt håll då Mått som antalet citeringar eller tidskriftsindikatorer fungerar generellt dåligt inom humaniora.

En möjlig väg är givetvis att svenska humanister anpassar sig till de gängse metoder inom andra fält. Att de likt bondgårdens djur i berättelsen om killingen accepterar räknandet som en nödvändighet för att överhuvudtaget synas, och i förlängningen överleva. En direkt kapitulation inför mätbarhetskraven är dock vare sig nödvändig, eller önskvärd. Snarare har den excellenshets som präglade forskningspolitiken under det tidiga 2000-talet kommit att ifrågasättas – inte minst i en Europeisk kontext, och med den de ganska ensidiga mått som används för att kvantifiera internationellt genomslag. I en diskussion där nu andra värden, som samverkan, öppenhet och samhällelig relevans, förhoppningsvis kan ges större plats så torde humanistiska och samhällsvetenskapliga perspektiv på vetenskaplig kvalité kunna få större genomslag. Humanister och samhällsvetare bör alltså inte nöja sig med att ihärdigt kritisera rådande kvalitetsmått, utan istället aktivt delta i utformandet av utvärderingsmetoder som överbryggar det gap som skisserats ovan. En sådan utveckling skulle gynna vetenskapssamhället i stort.

Men låt oss lämna nu lämna det generella för att istället fundera över vad detta mätande gör med den enskilde forskaren. Det finns säkert fler i publiken – som i likhet med mig – går omkring med ett ständigt mätinstrument vid sin handled. Min säger i detta nu att pulsen ligger på 73 slag och jag har hittills idag avverkat 3347 steg. Syftet med klockan är att mäta hur långt, och snabbt, jag springer men den kommer också att påverka hur långt jag springer, och kanske även hur jag springer. Till exempel utökar jag gärna min runda något för att hamna just över det antal kilometer som jag vill springa, klockan ger mig också råd om att löpa med kortare steg, och skulle jag mot förmodan (tyvärr sker det alltför sällan på sistone)slå ett rekord gällande fart eller sträcka så annonserar den det triumferande, och uppmuntrande.

Trenden att mäta och analysera sin egen prestation, eller för den delen sin kropp, med hjälp av digitala hjälpmedel har fått stor uppmärksamhet. Benämningen det kvantiferade jaget” lanserades för mer än 15 år sedan, och detta begrepp har även bäring inom akademin. I min forskning har jag särskilt tittat på plattformen ResearchGate. – ett slags forskningens Facebook. Sajten erbjuder användare att skapa en profil där den egna forskningen presenteras, och forskaren kan också följa kollegor för att på så sätt uppdateras kring deras verksamhet. Förutom att kalkylera olika mått så skickar ResearchGate ständiga meddelanden till sina användare, där ‘framgångar’ proklameras: ”du har tjugo nya läsare” eller ”dina publikationer har nu citerats 100 gånger”. Inom ramen för RG blir forskning som ett spel där målet är att samla så många poäng som möjligt. Vad dessa plattformar gör är att de ägnar sig åt ‘spelifiering’ (gamification). Spelifiering sägs kunna öka motivationen vid till exempel inlärning, men det har också använts för att höja produktiviteten i tillverkningsindustrin. Likadant kan RGs ständiga uppmaning att ‘uppdatera profilen’ och ‘ladda upp publikationer’ liknas vis det ständiga uppgraderandet av karaktärer i dataspel.

De finns många poänger i att granska de mer cyniska aspekterna av dessa kommersiella plattformar, men det finns andra sätt att titta på fenomenet av det kvantifierbara jaget. Den ständiga uppmaningen att förbättra sig, att bli ett bättre jag , har ett djupare ursprung än pulsklockor och social medieplattformar och denna strävan – som kan spåras tillbaka till åtminstone upplysningen och reformationen – är central för hur vi förstår oss själva. Här menar Helena Francke, och jag, in en uppföljande studie att en viktig funktion i alla dessa plattformar – mycket i likhet med hur sociala medier fungerar generellt – är att ge existentiell bekräftelse, att bli sedd, och uppmärksammad. Stor del av vår identitet är kopplade till arbetet, och en stor del arbete – mycket av allt kontorsarbete och kanske särskilt inom akademisk forskning – ger lite direkt återkoppling, och ofta tar det lång tid innan vi vet om någon ens läst det vi arbetat med. Plattformarna fyller därför en viktig funktion i att synliggöra ett ofta ganska osynligt arbete, att bekräfta att vi gör det vi ska, och att vi gör det bra.

Plattformarnas ständiga uppmaning till att uppdatera våra profiler bidrar även till en upplevelse av allt högre tempo. Flera faktorer bidrar till ytterligare tidspress. En tilltagande andel forskare och lärare har tillfälliga anställningar, forskningen bedrivs ofta inom tidsbegränsade, externt finansierade projekt och undervisningen – inte minst inom humaniora och samhällsvetenskap – bedrivs med färre lärarledda timmar. I kombination med en excellensretorik, som nu tyvärr åter tycks vara på modet igen i Svensk politik, förstärker också känslan av att inte räcka till. I stort sett alla lärosäten anser sig sträva efter excellens inom ett eller flera områden: Är du excellent lille vän är den fråga som ställs till varje medarbetare, och det gäller även undervisningen? Att ständigt avkrävas världsledande insatser skapar ytterligare stress och ger dem (i princip alla) som inte når upp till orimligt höga förväntningar dåligt samvete.

Ofta förstås ett ökat tempo i samhället som ett resultat av teknikutveckling med ökad produktionstakt och allt snabbare kommunikationer som följd. Forskning kring hur detta påverkar akademin skildrar en situation där publicering hastas fram, där allt mindre tid ges till läsning av allt det som skrivs och där administrativa krav och utvärderingar upptar en allt större del av arbetet. I värsta fall resulterar denna hets i en situation som kan liknas vid Hartmut Rosas tes om ett ”rusande stillastående” – alltmer produceras utan att egentliga intellektuella landvinningar görs. (vi springer allt snabbare i vårt ekorrhjul)

Publiceringsstressen leder enligt Vetenskapssociologen Ruth Müller till att beslut om forskning alltid fattas med framtiden i beaktande: kan detta projekt leda till publikationer – som i sin tur resulterat i en ny tjänst eller ett nytt projekt – som i nästa skede gör det möjligt att starta en egen forskargrupp osv. Detta innebär att möjliga samarbeten men även handledning av studenter främst bedöms utifrån deras potential till att frambringa publikationer. Då akademiska publikationer är avgörande för karriärens fortskridande finns det risk att uppgifter som inte resulterar i publikationer nedvärderas, och andra uppdrag som undervisning, handledning samt interaktion med samhället riskerar att bli nedprioriterade. Vidare kan publiceringsstressen leda till att “säkra” och kortsiktiga projekt (där publikationer garanteras) prioriteras framför mer nydanande och långsiktig forskning.

Hur ska vi då hantera tempot inom akademin? Finns det alternativ som gynnar både forskningens kvalitet och arbetsmiljön för den enskilde forskaren? Jag har ingen lösning tyvärr, men några reflektioner vill jag gärna dela med mig av:

För det första: För en stor del av de akademiskt verksamma är långsamhet helt enkelt inget alternativ.

Dessutom är det är uppenbart att en stor del av accelerationen genom teknikutveckling och ökad informationstillgång har haft en positiv inverkan på kunskapsproduktionen i samhället. Åtskilliga forskare framhåller att acceleration också är njutbart, och att perioder av högt tempo kan upplevas som både akademiskt givande och stimulerande. Uppenbarligen måste ett stegrat tempo i arbetet inte nödvändigtvis uppfattas som negativt, och speciellt gäller detta fall där accelerationen är initierad av forskaren själv. Kontroll över den egna arbetstiden samt möjligheten att själv bestämma tempo blir därmed avgörande för välbefinnandet, och för god forskning.

Uppmaningar till en generell temposänkning lär heller inte slå an hos beslutsfattare och en bredare allmänhet. I stället bör vi verka för akademiska miljöer som främjar ”ohastad” forskning och undervisning. Här bör kollegialiteten, och då inte minst seminariet, som en plats för eftertanke och reflektion framhållas. Till skillnad från forskningspublikationer, välputsade konferenspresentationer eller massföreläsningar så är det i seminariet som tankar föds, utmanas och utvecklas. Seminariet ligger inte till grund för någon medelstilldelning, ger inte några poäng i rankningar och sällan betonas dess roll för innovation och nyttiggörande, och just därför är det – än så länge – en relativt skyddad plats. ”Långsamhetsoaser”, som socilogen Hartmut Rosa skulle kalla dessa fredade rum, kan i sig inte hindra fortsatt acceleration, men förhoppningsvis erbjuda utrymme för återhämtning, reflektion och kreativitet i en jäktad akademi som bär på en ständig rädsla för att hamna på efterkälken.

Appropå tid börjar vi nu närma oss slutet på mitt anförande, och kanske är det dags att försöka sammanfatta och knyta ihop: Som ni fått höra så har en stor del av min forskargärning har ägnats åt att kritisera användningen av indikatorer som reducerar ytterst komplexa frågeställningar – vad är god forskning? – Till ett exakt numeriskt värde. Av det jag sagt hittills har också mycket ägnats åt en sådan kritik. Men räknandet har en funktion – inte bara i Pröjsens saga där bara ett visst antal djur får plats på färjan som för djuren i säkerhet – utan också när vi söker förstå vetenskapens utveckling. Bibliometrin är ett omistligt verktyg när vi försöker förstå hur vetenskapen struktureras, och det kan också användas för att direkt ifrågasätta rådande förhållanden. Det mest tydliga exemplet i en svensk kontext är kanske Irene Wennerås och Agnes Wolds analys rörande medicinska forskare som visade att kvinnor i medicinområdet behöver prestera mer än dubbelt så väl (i termer av publikationer och citeringar) för att rankas som jämbördiga med män. Resultaten av den studie var att hela det medicinska forskningsrådet omstrukturerades. Mätning kan ge makt och inflytande, och rätt använt kan bibliometrin användas för att ifrågasätta rådande missförhållanden och ojämlikheter.

Räknandet är därför inte vare sig ont eller gott i sig, utan snarare är det hur och när vi använder mått och indikatorer som är det centrala. Och kanske än viktigare i min egen forskning har varit att fråga sig varför vi mäter och räknar. Ofta mäter vi bara för att vi tror att vi måste – det är en ritual som behövs för ge legitimitet för handlingar och beslut, men vad måtten verkligen förmedlar förbli oklart.

Här är egentligen föreläsningen slut men nu sitter kanske en och annan i publiken och suktar, trots allt, efter lite räknande och mätande – det har ju varit förvånansvärt lite siffror) (och ni behöver nåt som konkret kan hjälpa er att bedöma kvaliteten i det ni fått höra), och därför kommer här som en bonus några mätpunkter: anförandet tog exakt 31 minuter (något långsammare än när jag repeterade, det skrivan manuset innehöll ord (3747 ord), antalet själförfattade bloggposter och kapitel som jag stulit text ifrån till denna föreläsning är 7, 13 andra forskare har nämnts, varav 6 kvinnor, 7 män, utöver dessa har även fyra djur, kalven, suggan, hästen och killingen, förekommit.

Flertalet av de jag samarbetat med under åren nämns dock inte, men de räknas ändå. Utan alla goda kollegor – många av dem här en hel del på andra på annat håll – min familj (särskilt Linda min första och bästa läsare), och vänner så hade det inte varit nån professorsföreläsning. Inte heller efterföljande bubbel och mingel.

Tack, jag är så glad att ni är här idag, och nu har ni lyssnat klart.

Skärmavbild tagen av Jesse Dinneen

(från utlåtande i biomedicin)

(från utlåtande i biomedicin)