(Detta är en utökad version av en text som först publicerats på humtanks blogg]

Utvärderingsgapet, en term lanserad av vetenskapssociologen Paul Wouters, illustrerar en ofta förekommande diskrepans mellan det vi värderar högt och det som man kan mäta värdet på. Ett tydligt exempel är försöken att konstruera indikatorer som på basis av publikationer och citeringar skall mäta forskningens kvalité. Även om det idag råder konsensus om att citeringar i bästa fall kan betraktas som en indikation på synlighet och genomslag i forskningssamhället så spelar fortfarande bibliometriska mått en avgörande roll i fördelningen av resurser och vid tillsättningar av akademiska tjänster. Istället för att bedöma utifrån de kriterier som vi anser bäst reflektera kvalité och relevans får tillgänglig data samt enkelheten i genomförande i hög grad styra hur forskning utvärderas.

Diskrepansen mellan bibliometriska mått, exempelvis citeringar, och det de är avsedda att mäta har uppmärksammats inom forskningspolitiken i stort, och vikten av att använda indikatorer på ett ansvarsfullt sätt har alltmer betonats. Ett exempel är det uppmärksammade Leiden Manifesto on Research Metrics, samt DORA, ett världsomspännande upprop mot användandet av ‘Journal Impact Factor’ som mått på kvalité. Kritiken mot bibliometrisk utvärdering har, med rätta, varit särskilt hård från ett samhällsvetenskapligt och humanistiskt håll. Mått som antalet citeringar eller ‘impact factors’ för tidskrifter fungerar generellt dåligt inom humaniora, där publicerings- och citeringsmönster gör att mycket liten del av alla publikationer räknas i sådana system. Modeller likt den norska listan, där även monografier och bokkapitel ger poäng utifrån fastställda kvalitetsnivåer (1 eller 2) har därför blivit populära. Just den norska modellen används också vid flera lärosäten runt om i landet. Vi vet dock mindre om hur enskilda forskare inom humaniora förhåller sig till den uppsjö av bibliometriska indikatorer som finns att tillgå. Till mer etablerade mått som citeringar och tidskriftsrankningar sållar sig nu en grupp av alternativa mått (så kallade altmetrics) samt digitala plattformar som ResearchGate och Academia.edu vilka alla säger sig kunna ge indikationer på forskningens genomslag och synlighet. En första överblick gällande hur forskare inom humaniora i Sverige använder sig av dessa mått och tjänster ges i en nyligen publicerad undersökning, Conflicting measures and values: How humanities scholars in Australia and Sweden use and react to bibliometric indicators, där Gaby Haddow och jag analyserar svaren från 420 humanistiska forskare (varav 263 från Sverige). Generellt fann vi att australiensiska humanister (62 %) i mycket högre grad än svenska (14 %) använde sig av bibliometriska mått och indikatorer. Förklaringen till den stora skillnaden står förmodligen att finna i skillnader gällande språk (engelskspråkiga publikationer är ofta enklare att utvärdera med bibliometri), skillnader i hur forskning och högre utbildning är organiserade i de två länderna, samt i att Australien till skillnad från Sverige har en lång historia av bibliometrisk utvärdering bakom sig. Jämförelsevis fann vi ganska små skillnader mellan olika forskningsområden, men inte helt oväntat visade det sig att discipliner där forskarna i större utsträckning publicerar sig i tidskrifter, exempelvis filosofi, var mer benägna att använda bibliometriska mått.

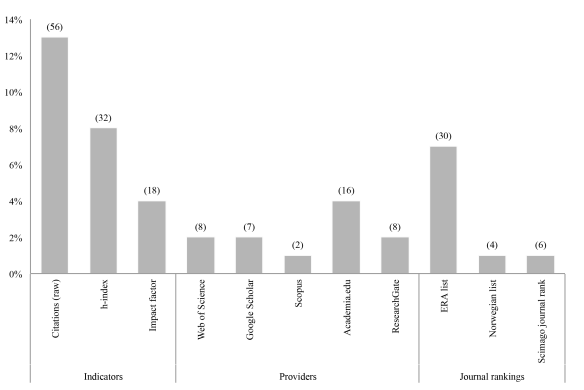

Noterbart var den uppsjö av metriker och rankingar som forskarna begagnade sig av. Mer etablerade indikatorer såsom citeringar, journal impact factor och h-index (ett individbaserat och starkt kritiserat mått) nämndes givetvis av våra respondenter, men mer alternativa sätt att mäta genomslag, såsom nedladdningar och visningar, förekom också (fig 1).

Figur 1. Humanisters användning av indikatorer, datakällor och tidskriftsrankningar

Överlag kan det konstateras att forskarna omges av ett evalueringslandskap där en rik flora av mått finns att tillgå, och det är inte helt ovanligt att dessa jämförs med varandra. Exempelvis kan, såsom i detta australiensiska fall, en mer gynnsam och passande mätmetod spelas ut mot institutionella krav:

Only reason [för att använda citeringar] is to ward off any criticism that journal articles are not in A* or A ranked journals. High citations of articles in decent B-level journals should count for something, even though department policy is to discourage and/or ignore them (Australiensisk forskare, historia och arkeologi).

Flera av våra respondenter riktade skarp kritik mot användningen av bibliometriska mått – i ett av de mer hårda omdömena beskrivs bibliometri som ett: “unholy marriage of market capitalism and Stakhanovist micro-management”. Informanten fortsätter med att likna forskare i detta system vid hönor i bur, som tvingas att producera ett visst antal artiklar varje år. Mindre drastiskt kritik förekom också, och ett flertal forskare, inte minst inom fält som historia och litteraturvetenskap, kopplar bibliometriska indikatorer till mer generella förskjutningar i publiceringspraktiker där den engelskspråkiga tidskriftsartikeln får ökad betydelse. Huruvida dessa förändringar direkt går att härleda till bibliometrisk utvärdering framstår dock som oklart av rådande forskningsläge att döma. Snarare bör vi nog se det som att dessa mått accentuerar en redan pågående utveckling i denna riktning. I sammanhanget får vi heller inte glömma att en del forskare snarare välkomnar de förändringar som bibliometrin sägs påskynda:

Shift to publishing in English and emphasis on publishing in peer review journals (thank god). Hopefully this decreases the degree of laziness among researchers in my field” (svensk postdok, historia och arkeologi).

De bibliometriska måtten blir därmed en del av en diskursiv kamp inom enskilda forskningsfält där traditionella sätt att publicera sig (på svenska, i bokkapitel eller monografier) ställs mot nya praktiker där publicering i en engelskspråkiga tidskrifter framhålls. I delar kan denna fråga ses som en konflikt mellan generationer, och inte minst äldre forskare hänfaller ofta åt nostalgiska betraktelser av en förfluten tid utan bibliometri och publiceringsstrategier:

Fortunately, I am old and consequently I do not have to bother. Had I been young, I would have left academia rather than adjust to the moronic ‘publishing strategies’ forced upon us (svensk, lektor, arkeologi- och historia).

Delvis finns det poänger i detta resonemang; unga forskare är i en mer utsatt position då de ofta har osäkra anställningsförhållanden och de är därför tvungna att tänka mer ‘strategiskt’. Vidare finns det en risk att mer långsiktiga och riskabla projekt överges till förmån för forskning som snabbt kan ge utdelning i form av publikationer och citeringar. Samtidigt döljer utsagor likt dessa att det även förr fanns ‘publiceringstrategier’ där det exempelvis kunde vara av stor betydelse för den yngre forskaren att hålla sig väl med etablerade professorer som i rollen av redaktörer för antologier och bokserier kunde (och fortfarande kan) gynna en begynnande karriär. Vidare är det viktigt att framhålla att dessa två strategier knappast står i direkt konflikt med varandra. Snarare utmärks framgångsrika humanistiska forskare ofta av en förmåga att rikta sig till relevanta publiker både nationellt och internationellt, och inte sällan publicerar de sig i en rad forum och på olika språk.

Även om en del av kritiken mot bibliometrin bör ses som förklädda argument i inomdisciplinära strider så är utvärderandet av humaniora med hjälp av kvantitativa mått problematiskt på flera plan. En given invändning, ofta anförd i litteraturen, är det faktum att humanistisk forskning till stor del inte finns representerad i de bibliometriska databaserna, och detsamma gäller även flera av de alternativa mått som på senare år lanserats. På ett djupare plan är det även så att bibliometriska indikatorer rimmar illa med etablerade kvalitetsbegrepp och värderingspraktiker inom humaniora. En av våra australiensiska respondenter uttrycker det som ett problem i att översätta värden mellan olika sfärer: “… translating our sense of value to people who want quantitative data”. En grundläggande konflikt mellan radikalt olika sätt att tänka kring vetenskapligt värde skönjs här där då de snäva idéer om produktivitet, effektivitet och konkurrens som bibliometrin bygger på svårligen kan appliceras i en humanistisk kontext. Gapet mellan vad bibliometrin mäter och värderar, och vad som vanligen värderas som kvalité inom humanistisk forskning är således stor. Bland svenska humanister har ännu inte heller bibliometriska mått slagit igenom på allvar. Vår studie visar dock att situationen ser annorlunda ut i Australien, där forskarna trots protester och berättigad kritik, använder dessa mått i stor utsträckning.

Hur utvärderingsgapet ska överbryggas i framtiden framstår som oklart: Ska svenska humanister anpassa sig till de metoder som finns tillgängliga (en utveckling som kan skönjas internationellt), eller kan vi behålla och utveckla utvärderingspraktiker som i högre grad inkorporerar en bredare förståelse av kvalité? Min slutsats är att humanisterna inte bör nöja sig med att ihärdigt kritisera rådande kvalitetsmått, utan istället aktivt delta i utformandet av utvärderingssystem som överbryggar det gap som skisserats ovan. En sådan utveckling skulle inte bara gynna humaniora utan även vetenskapssamhället i stort.

Bild: Rafaela Ely (Bournemouth) [CC BY 2.0 (https://creativecommons.org/licenses/by/2.0)%5D, via Wikimedia Commons

(från utlåtande i biomedicin)

(från utlåtande i biomedicin)